Meta publiserer koden i åpen tilgang kunstig intelligens under navnet bildebind, som forutsier forhold mellom data som ligner på hvordan folk oppfatter eller forestiller seg miljøet sitt. Mens bildegeneratorer som Midjourney, Stable Diffusion og DALL-E 2 binder ord til bilder, slik at du kan lage visuelle scener basert på bare en tekstbeskrivelse, går ImageBind utover det. Den kan koble sammen tekst, bilder eller video, lyd, 3D-målinger, temperaturdata og bevegelsesdata – og gjør det uten behov for forhåndstrening ved enhver anledning. Dette er et tidlig stadium av et rammeverk som til slutt vil kunne generere komplekse miljøer fra enkle innganger som en tekstmelding, bilde eller lyd (eller en kombinasjon av disse).

Du kan tenke på ImageBind som en tilnærming av maskinlæring til menneskelig læring. Hvis du for eksempel står i et dynamisk miljø, for eksempel en travel bygate, absorberer hjernen din (for det meste ubevisst) syn, lyder og andre sansefornemmelser for å få informasjon om forbipasserende biler, høye bygninger, været og mer . Mennesker og andre dyr har utviklet seg til å behandle disse dataene for våre genetiske fordeler: overlevelse og videreformidling av vårt DNA. (Jo mer du vet om omgivelsene dine, jo mer kan du unngå fare og tilpasse deg miljøet ditt for bedre å overleve og trives). Etter hvert som datamaskiner kommer nærmere å etterligne de multisensoriske forbindelsene til dyr, kan de bruke disse forbindelsene til å generere fullt realiserte scener basert på bare begrensede data.

Så mens du kanskje bruker Midjourney til å lage "en bassethund i en Gandalf-kostyme som balanserer på en badeball" og få et relativt realistisk bilde av den merkelige scenen, kan et multimodalt AI-verktøy som ImageBind ende opp med å lage en video med hunden med relevant lyder, inkludert en detaljert stue, romtemperatur og den nøyaktige plasseringen til hunden og alle andre i scenen. "Dette skaper en utmerket mulighet til å lage animasjoner fra statiske bilder ved å kombinere dem med lydmeldinger," noterer Meta-forskerne i sin utviklerorienterte blogg. "For eksempel kan en skaper kombinere et bilde med en vekkerklokke og en galende hane og bruke et lydsignal for å segmentere hanen eller lyden av vekkerklokken for å segmentere klokken og animere begge deler i en videosekvens."

Når det gjelder hva annet som kan gjøres med dette nye leketøyet, peker det tydelig på en av Metas kjerneambisjoner: VR, mixed reality og metaspace. Tenk deg for eksempel et fremtidig hodesett som kan bygge fullt realiserte 3D-scener (med lyd, bevegelse osv.) på farten. Eller virtuelle spillutviklere kan til slutt bruke det til å spare seg selv for en betydelig del av det møysommelige arbeidet i designprosessen. På samme måte kan innholdsskapere lage oppslukende videoer med realistiske lydspor og bevegelse basert på bare tekst, bilder eller lyd. Det er også lett å forestille seg hvordan et verktøy som ImageBind åpner nye dører innen tilgjengelighet ved å generere sanntids multimediebeskrivelser for å hjelpe personer med syns- eller hørselshemninger bedre å forstå miljøet sitt.

Også interessant: De beste verktøyene basert på kunstig intelligens

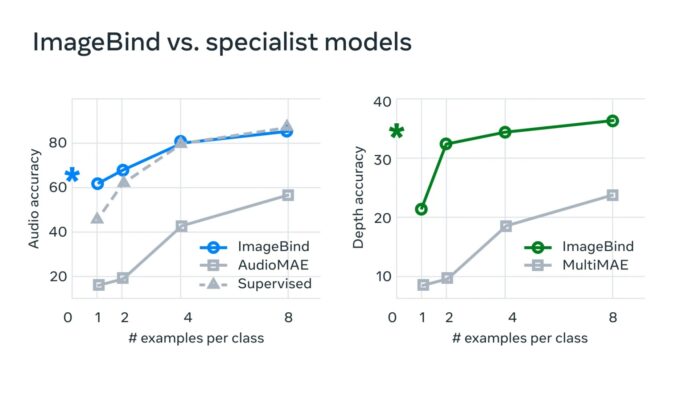

"I typiske AI-systemer er det en spesifikk innebygging (dvs. vektorer av tall som kan representere data og deres relasjoner i maskinlæring) for hver relevant modalitet," sier Meta. «ImageBind viser at det er mulig å skape et felles innebyggingsrom for flere modaliteter uten å trene på data med hver enkelt kombinasjon av modaliteter. Dette er viktig fordi forskere ikke kan lage datasett med prøver som inneholder for eksempel lyddata og termiske data fra en travel bygate, eller dybdedata og en tekstlig beskrivelse av en klippe ved havet.»

Meta tror at denne teknologien etter hvert vil gå utover dagens seks «sanser», for å si det sånn. "Selv om vi undersøkte seks modaliteter i vår nåværende studie, tror vi at å introdusere nye modaliteter som kobler sammen så mange sanser som mulig - som berøring, tale, lukt og fMRI-hjernesignaler - vil gi rikere menneskesentriske AI-modeller." Utviklere som er interessert i å utforske denne nye sandkassen kan starte med å dykke inn i Metas åpne kildekode.

Les også: